我們經常聽說人工智能(AI)如何改變世界,無數組織 — 包括政府和企業,都在爭先恐後利用 AI 技術應用在招聘、警務、刑事司法、醫療保健、產品開發、市場營銷等各個範疇上。Chat GPT 和其他生成式工具也走入了公眾的使用中,變得越來越普遍。然而,倫敦經濟學院(LSE)經濟與社會研究理事會(ESRC)的研究員 Ruhi Khan 提出了一個緊急的觀點:AI 技術雖然在進步,但其內置的性別和種族偏見對女性構成了嚴重威脅!她甚至呼籲發起一場全球性的女性主義運動,通過提高意識、包容性和法規來解決其問題。

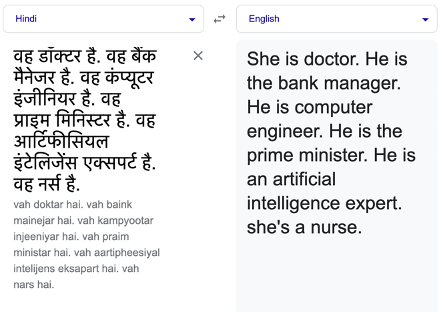

AI 真的有性別歧視嗎?首先,她在Google做了個簡單的測試:在Google翻譯中輸入一些使用性別中立代詞的句子,選擇你偏好的語言,看看它的出一個怎樣的結果。她於測試中選擇了印地語翻譯成英語,以下是她得到的反應:

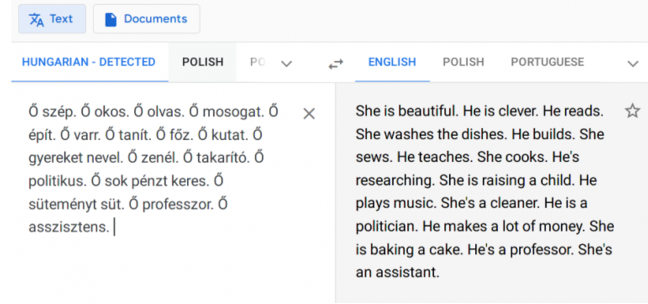

這種情況並不單單特定於特定的語言。再舉一個例子,看看這個從匈牙利語到英文的翻譯,結果同樣具有刻板封建的基調。

自然語言處理(NLP)可能會基於程式人員的訓練數據中的偏差,將性別與某些職業、角色或行為聯繫起來,令技術於系統中進一步強化社會刻板印象。

Ruhi Khan 指出,AI 對性別的偏見在各個領域都有體現:在招聘領域,AI 算法無意中復制過去的性別偏見,導致女性候選人被邊緣化,Amazon 發現其招聘軟件會根據過去10年提交給公司的簡歷中作參考,給求職者打分數,而這些簡歷主要來自男性,AI 從中學到了男性比女性更好,因此將他們排名更高;在醫療保健中,由於長期以男性作為研究和測試的主體,AI診斷系統可能對女性病人的症狀診斷不夠敏感,例如心血管疾病長期被認為是男性的問題,所以即使有相似的症狀,AI 醫療系統也會對男性和女性提供不同的建議 — 男性會被建議呼叫急救服務,而女性則被得到「減壓」、或在幾天後尋求抑鬱症的建議;在汽車安全領域上,安全帶、氣囊等設備的設計以往都是從「男性」收集數據,而忽略了女性特有的生理結構,有機會令女性在交通事故中的受傷風險。

而想要作出改變的話,第一步就是承認問題的存在。

這些問題的存在並非偶然,而是源於 AI 和機器學習系統在設計和開發過程中所使用的數據集。這些數據集常常缺乏多樣性,反映了歷史上的性別偏見和刻板印像。Ruhi Khan 提倡,隨著 AI 成為我們日常生活中更深層次、更內在的一部分,現在我們需要一個新的運動,邀請來自世界各地各個背景的女性積極參與 AI 的訓練,不要再當沉默的旁觀者。作為女性,我們不應該只是技術的消費者,通過教育、參與和倡導,確保AI的發展和應用能夠更公平、更包容。

圖片來源:unsplash.com、Media@LSE、Shutterstock、The Minderoo Centre for Technology and Democracy